FacebookAI将在计算机视觉众多重要领域的最新进展

目前关于到FacebookAI将在计算机视觉众多重要领域的最新进展这一类的信息是很多小伙伴们都非常关心的,很多人也是经常在搜索关于FacebookAI将在计算机视觉众多重要领域的最新进展方面的信息,那么既然现在大家都想要知道此类的信息,小编就收集了一些相关的信息分享给大家。

来自世界各地的计算机视觉研究者和工程师将在6月14日至19日举行的2020年计算机视觉和模式识别大会(Conference on Computer Vision and Pattern Recognition;CVPR)共聚一堂,而Facebook AI团队将通过演示,教程,研讨会,在线互动问答等方式展示相关的研究成果。

对于今年的CVPR大会,Facebook AI将介绍在计算机视觉众多重要领域的最新进展,包括核心分割任务,架构搜索,转移学习和多模态学习。团队同时将分享多项以新方法解释在常规二维图像显示的三维对象的论文等。这家公司指出:“新研究可以帮助我们解锁虚拟现实和增强现实的创新,以及其他未来体验。”

下面是Facebook将要在CVPR大会介绍的与AR/VR相关的论文及摘要:

1. Novel views from only a single image in complex, real-world scenes

我们构建了一个先进的端到端模型SynSin,它可以获取单个RGB图像,然后从不同的角度生成同一场景的新图像,无需任何3D监督。我们系统主要是预测一个3D点云,后者通过PyTorch3D使用我们的可微渲染器投射到新的视图上,并且将渲染的点云传递到生成对抗网络(GAN)来合成输出图像。当前的方法通常是使用密集体素网格,它们在单个对象的合成场景中显示出优秀的应用前景,但无法扩展到复杂的真实场景。

利用点云的灵活性,SynSin不仅能够实现这一点,而且比体素网格等替代方法更有效地推广到各种分辨率。SynSin的高效率可以帮助我们探索广泛的应用,如生成更好的3D照片和360度视频。

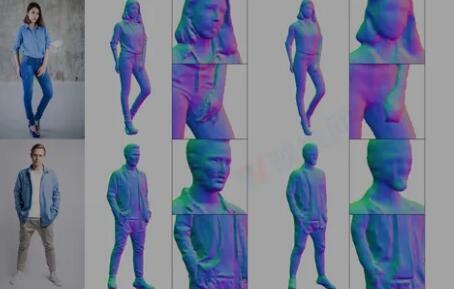

2. Reconstructing 3D human figures in unprecedented level of detail and quality from a single image

我们开发了一种从二维图像中生成高质量和高细节的三维人物重建。它利用高分辨率照片作为输入,并捕获手指、面部特征和衣服褶皱等高度复杂细节。对于以前的技术,如果不进行额外处理,这根本无法实现。

为了实现这一目标,我们以高记忆效率的像素对齐隐式函数(Pixel-Aligned Implicit Functionn;PIFu)作为基础,并建立了一个层次化的多级神经网络结构,然后对全局细节和局部细节进行处理,从而实现高分辨率的三维重建。第一级网络利用较低分辨率的输入图像来考量人体的整体三维结构,类似于PIFu函数。第二级网络是一个轻量级网络,它可以获取更高1K分辨率的输入图像来分析局部细节。通过从一级网络访问全局三维信息,我们的系统可以有效地利用局部信息和全局信息进行高分辨率的三维人体重建。下面是我们方法与其他先进方法相比的定性结果:

这种高精细的详细三维重建可以帮助优化重要的应用,如创建更为真实的虚拟现实体验。

3. ARCH: Animatable Reconstruction of Clothed Humans

论文提出了一种新颖的端到端框架ARCH(Animatable Reconstruction of clother Humans),它可从单目图像中精确重建可马上用于动画的3D穿衣人类。现有的数字化三维人体方法难以处理姿势变化和恢复细节,而且它们无法生成可马上用于动画的模型。相比之下,ARCH是一种经过学习的姿势感知模型,可以从一个无约束的RGB图像生成详细的3D Rigged虚拟化身。我们利用参数化三维体估计器建立语义空间和语义变形场。它们允许将身穿2D/3D服装的人类转换成一个规范化空间,并减少由姿势变化和训练数据中的遮挡而造成的几何模糊。详细的曲面几何和外观是利用具有空间局部特征的隐式函数表示来学习。另外,我们额外提出了使用不透明感知的可微渲染来进行逐像素监督的三维重建。我们的实验表明,ARCH提高了重建人类的逼真度。与基于公共数据集的最新方法相比,标准度量的重建误差降低了50%以上。我们同时展示了迄今为止文献所不存在的大量高质量重建动画化身示例。

4. Epipolar transformers

在同步和校准的多视图设置中,定位三维人体关节的常用方法包括两个步骤:1.分别在每个视图应用二维检测器来定位二维关节;2.对每个视图中的二维检测执行鲁棒三角剖分以获取三维关节位置。但在步骤1中,二维检测器仅限于解决可能在三维中能更好解决的挑战性情况,如遮挡和斜视角,亦即纯粹在二维中而不利用任何三维信息。所以我们提出了可微的“极线变换器”,这使得二维探测器能够利用三维感知特征来改进二维姿势估计。原理是:给定当前视图中的二维位置p,我们希望首先在相邻视图中找到其对应的点p0,然后将p0处的特征与p处的特征相结合,从而在p处产生一个三维感知特征。受立体匹配启发,极线变换器利用极线约束和特征匹配来逼近p0处的特征。InterHand和Human3.6M的实验表明,我们的方法比基线有一致的改进。具体来说,在不使用外部数据的情况下,我们使用ResNet-50 backbone和256×256图像大小训练的Human3.6M模型在性能方面比现有模型高4.23mm,达到了MPJPE 26.9mm。代码可用。

5. ImVoteNet: Boosting 3D object detection in point clouds with image votes

由于点云深度学习的进步,三维目标检测已经取得了快速的进展。最近甚至有研究展示了单纯利用点云输入的效果,如VOTENET。然而,点云数据有其固有的局限性。它们属于稀疏型数据,缺乏颜色信息,并且经常受到传感器噪点的影响。另一方面,图像具有高分辨率和丰富纹理。所以,它们可以补充点云提供的三维几何图形。不过,如何有效地利用图像信息来辅助点云检测依然是一个悬而未决的问题。我们的研究将VOTENET作为基础,并提出了一种基于RGB-D场景的三维检测结构IMVOTENET。IMVOTENET是基于融合图像中的2D vote和点云中的3D vote。与以往的多模态检测相比,我们从二维图像中显式提取出几何特征和语义特征。我们利用摄像头参数将特征提升到3D。为了提高2D-3D特征融合的协同性,我们同时提出了一种multitower训练机制。我们在具有挑战性的SUN-RGB-D数据集验证模型,并以5.7map实现了高质量的结果。我们同时提供了丰富的模型简化测试来分析每个设计选择的贡献。

6. Lightweight multiview 3D pose estimation through camera-disentangled representation

对于从空间校准摄像头捕获的多视图图像中恢复三维姿势,我们提出了一个轻量级的解决方案。根据可解释表示学习的最新进展,我们利用三维几何将输入图像融合到一个统一的潜在姿势表示中,其中姿势表示从摄像头视角中分离出来。通过这样的方式,我们无需使用计算密集型体三维网格就能有效地推理不同视图的三维姿势。然后,我们的架构将学习到的表示条件应用到摄像头投影算符,从而生成精确的逐视图二维检测。其中,所述检测能够通过可微直接线性变换(Direct Linear Transform;DLT)层简单地提升到3D。为了有效地实现这一点,我们提出了一种新的DLT实现方法,而这种实现在GPU架构上比基于SVD的标准三角剖分方法快了几个数量级。我们在两个大规模人体姿势数据集(H36M和Total Capture)上评估了我们的方法:我们的方法比最新的体三维法有更好的性能,或者说性能相当,但与它们不同的是,我们的方法能够产生实时性能。

8. PointRend: Image segmentation as rendering

我们提出了一种有效的高质量图像分割方法。通过将用于有效渲染的传统计算机图形学方法类比成像素标记任务中的过采样和欠采样挑战,我们提出了一种将图像分割作为渲染问题的独特视角。从这个角度出发,我们提出了PointRend(Point-based Rendering)神经网络模块。这个模块会根据迭代细分算法在自适应选择的位置执行基于点的分割预测。PointRend能够以现有的最新模型作为基础,并灵活地应用于实例和语义分割任务。尽管总体思路的众多具体实现可行,但我们的研究表明,一个简单的设计已经能够取得了优秀的效果。从质量上讲,对于以前方法过度平滑的区域,PointRend能够输出清晰的对象边界。从数量上讲,PointRend在COCO和cityscape上都获得了显著的增益,涵盖实例和语义分割。对于现有方法因内存或计算方面不切实际而无法实现的输出分辨率,现在PointRend的效率已经使之成为可能。代码已经托管到GitHub。

9. You2Me: Inferring body pose in egocentric video via first and second person interactions

对于穿戴摄像头的用户的身体姿势,其对增强现实,医疗健康和机器人等应用非常重要,但用户身体的大部分都不位于穿戴式摄像头的视场之内。我们提出了一种基于学习的方法来从Egocentric视频序列中估计摄像头穿戴者的三维身体姿势。我们的关键见解是,将与另一个人的互动(我们可以直接观察到他/她的身体姿势)作为与第一人称被试身体姿势固有系的信号。我们的研究表示,由于个体之间的互动通常会导致一系列有序的前后反应,所以即使一方基本上是不可见,我们都有可能发现相互关姿势的时间模型。我们利用二元互动在多个领域展示了我们的概念,并展示了对Egocentric身体姿势估计的实质性影响(显著提升)。